Volumen 19

Número 5, septiembe – octubre

natalinadi@yahoo.com.mx

Profesora de tiempo completo en el Departamento de Anatomía de la Facultad de

Medicina de la Universidad Nacional Autónoma de México (UNAM) donde es co-

responsable del laboratorio de Ritmos biológicos y Metabolismo. Pertenece al

Sistema Nacional de Investigadores (SNI nivel I). Es Bióloga por la Facultad de

Ciencias, UNAM (2009) y doctora en Ciencias, UNAM (2015). Participa en

actividades docentes en la UNAM y en la Universidad Panamericana. Ha publicado

diversos artículos en revistas internacionales y ha presentado su trabajo de

investigación en congresos nacionales e internacionales. Su línea de investigación

se enfoca en entender como diversos procesos que alteran los ritmos circadianos

promueven el desarrollo de enfermedades.

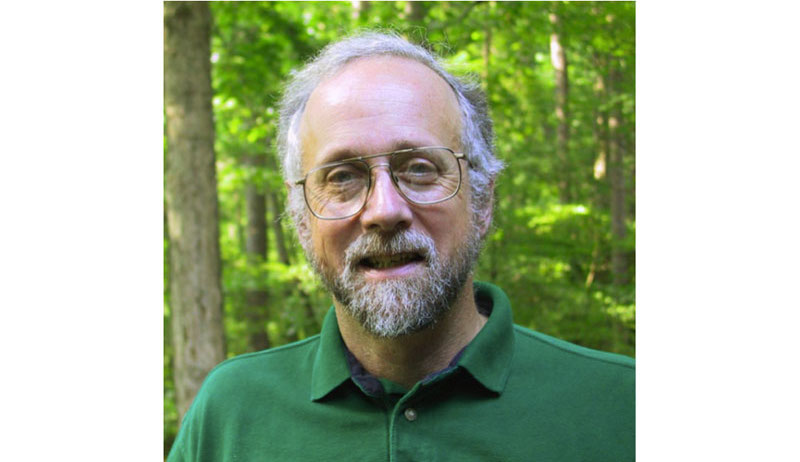

Profesor de tiempo completo y Jefe del Departamento de Anatomía de la Facultad

de Medicina de la Universidad Nacional Autónoma de México (UNAM), es

responsable del laboratorio de Cronobiología. Pertenece al Sistema Nacional de

Investigadores (SNI nivel I). Es Médico Cirujano. Egresado de la Facultad de

Medicina y Cirugía de la Universidad Benito Juárez de Oaxaca (1991-1997) y

doctor en Ciencias Biomédicas (2005) por la UNAM. Es miembro regular de la

academia nacional de medicina de México. Sus líneas de investigación:

contribución del alimento palatable (chocolate) en los mecanismos centrales de re-

sincronización del sistema circadiano, después de un avance de fase de seis

horas.

escocarolina@gmail.com

Profesora de tiempo completo en el Departamento de Anatomía de la Facultad de

Medicina UNAM, donde actualmente funge como coordinadora de investigación y

es responsable del laboratorio de Ritmos biológicos y metabolismo. Es profesora

de asignatura en la Facultad de Psicología de la misma universidad. Pertenece al

Sistema Nacional de Investigadores (SNI nivel III). Cuenta con más de 140

publicaciones. Fungió como editora en dos números de la revista Biological

Rhythms Research (1998 y 2005) y para un número especial la revista Ciencia

(2008) de la Academia Mexicana de Ciencias titulado “Ritmos biológicos”. Desde el

2013 es miembro del Comité editorial de la revista Biological Rhythms Research.

Sus líneas de investigación: el alimento como factor de desincronización

circadiano, modelos de desincronización circadiana para el estudio de la obesidad,

la sincronización por alimento como desencadenante de adicción.

Descarga

Introducción

Test

Titulo dos

Titulo tres

Los efectos adversos de la luz artificial por la noche

Adverse effects of artificial light at night

I am text block. Click edit button to change this text. Lorem ipsum dolor sit amet, consectetur adipiscing elit. Ut elit tellus, luctus nec ullamcorper mattis, pulvinar dapibus leo.

I am text block. Click edit button to change this text. Lorem ipsum dolor sit amet, consectetur adipiscing elit. Ut elit tellus, luctus nec ullamcorper mattis, pulvinar dapibus leo.

http://doi.org/10.22201/codeic.16076079e.2018.v19n4.a3

Subtitulo 1

Subtitulo 2

Subtitulo 3

“La mucha luz es como la much adqwdq wdqwwqdwqdqwdqwdqwdw qdwqdwqdwqdq wdwqdqdqwdqwdqw dqwdqwdqwdqwdqwdq sombra: no deja ver… wdqdqdqwd qwdqwdqwdqwdqw”. Octavio Paz

Cita a bando

Nuestro cuerpo tiene un reloj biológico y todos los tejidos son osciladores que siguen al ciclo diario de luz-oscuridad para poder cambiar la intensidad de la conducta y nuestras funciones fisiológicas y de esta forma hacernos más eficientes según si estamos

despiertos o dormidos.

- uno

- dos

- tres

- cuatro

- uno

- dos

- tres

- cuatro

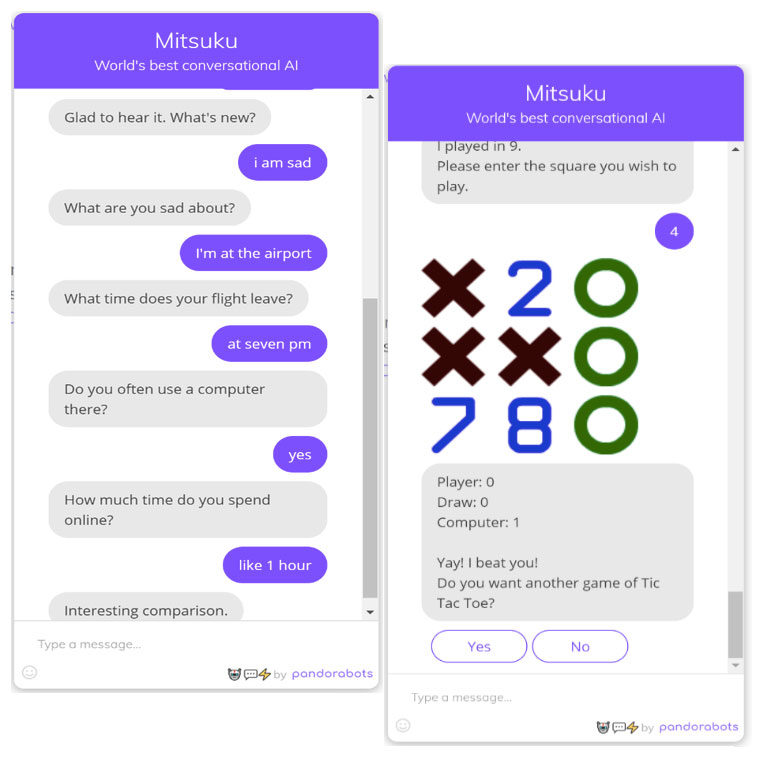

The negative effects of artificial light at nightNuestro reloj biológico reconoce cuando está oscuro y cuando hay luz y lo interpreta como día y noche. Con el uso de la luz eléctrica, que comenzó alrededor del siglo pasado, este sistema temporal ha sido alterada.

Los científicos han

comenzado a señalar que la exposición a la luz por la noche confunde al reloj biológico lo

cual puede tener consecuencias sociales, ecológicas, conductuales y para la salud. Las

personas que se exponen a la luz eléctrica por largas horas durante la noche son las más

afectadas, particularmente los trabajadores nocturnos. Sin embargo, cambios en el estilo

de vida han llevado a que jóvenes y niños se expongan desde edades tempranas a este

fenómeno conocido como “contaminación lumínica”. En este texto pretendemos exhibir las

evidencias clínicas y experimentales que indican que la luz artificial por la noche es un

factor adverso, promotor de alteraciones en el sistema circadiano, en la fisiología y, por lo

tanto, la contaminación lumínica es un factor de riesgo para la salud pública.

Palabras clave: ritmos circadianos, contaminación lumínica, depresión, alteraciones

circadianas, síndrome metabólico, cáncer.

Abstract

Our body has a biological clock and all tissues are oscillators that follow the daily light-dark

cycle in order to change the intensity of behavior and physiological functions and make us

more efficient according to whether we are awake or asleep. The invention and use of

electric lights, which began around the last century, have affected this temporal

organization. Light exposure at night has social, ecological, behavioral and health

consequences that just now begin to be apparent. People with nocturnal habits are mostly

exposed to light at night, and among them night workers are at risk. Due to changes in life

style, young people, including children, are now individuals exposed to this factor that

affects their physiology. The excess of light at night, also called “light pollution”, is the

cause of diverse health problems. The aim of this paper is to present evidence from

clinical studies and experimental models that points out the deleterious effects of light at

night as a factor that affects the circadian system, physiological systems and behavior

leading to disease. Here we offer evidence that light at night is a risk factor for public

health.

Keywords: circadian rhythms, light pollution, depression, circadian disruption, metabolic

syndrome, cancer.

Introducción: el sistema circadiano y la luz como señal de tiempo

(St1)

La sociedad moderna ha adoptado un estilo de vida que violenta la organización temporal de nuestra conducta y fisiología. Las condiciones ambientales del día y la noche que se requieren para ajustar las diversas funciones fisiológicas en nuestro organismo se respetan poco y esto afecta la eficiencia con la que nos adaptamos y respondemos a los cambios del medio ambiente externo. Nuestra adaptación al ciclo luz-oscuridad depende del sistema circadiano, que tiene la función de monitorear señales temporales externas y transmitirlas al resto del cuerpo. El sistema circadiano consiste en una especie de reloj principal (Buijs y Kalsbeek, 2001), localizado en el cerebro llamado núcleo supraquiasmático (NSQ) y por su interacción con tejidos del cuerpo con capacidad de oscilar con ciclos de 24 horas, conocidos como osciladores periféricos (Buijs, van Eden, Goncharuk y Kalsbeek, 2003).

4

Figura 1. Esquema del sistema circadiano.

Este reloj biológico transmite ritmos de 24 horas a todos los tejidos por

medio de señales neurales y señales hormonales (melatonina y corticosterona).

Por este proceso se logra que la conducta y las funciones internas respondan de

forma coordinada dependiendo de la hora del día, lo cual se conoce como

sincronización circadiana. Cuando el individuo realiza actividades en conflicto con

las señales del reloj biológico, por ejemplo, encender la luz cuando debería de

estar oscuro, se provoca una desincronización circadiana, lo cual lleva a que

muchas funciones se realicen con una intensidad inadecuada para los

requerimientos del ambiente (ver figura 1).

La referencia temporal más potente que rige al sistema circadiano es la

alternancia del ciclo luz-oscuridad y son las células 1 de la retina las que le

comunican al reloj biológico el estado de luminosidad correspondiente al día y la

noche. La señal de luz activa a las neuronas del NSQ y activa genes cíclicos

1 Las células ganglionares son un tipo de neurona localizada en la retina del ojo.

5

conocidos como genes reloj, que miden el tiempo a nivel celular (Golombek y

Rosenstein, 2010). Otros eventos externos cíclicos que también afectan al sistema

circadiano son los cambios de temperatura, sonidos sociales, el consumo de

alimento, etcétera (Danilenko, Cajochen y Wirz-Justice, 2003; Klerman et al.,

1998).

El NSQ impone ciclos de

actividad a otras áreas cerebrales

para darle tiempo a la conducta y

para transmitir señales de tiempo

al resto del organismo a través

de proyecciones del sistema

nervioso autónomo y por medio

la producción de la hormona

melatonina –secretada por la

glándula pineal– y la

corticosterona –producida por el

eje hipotálamo-hipófisis-adrenal–

(Kalsbeek et al., 2006). Los

tejidos del cuerpo reconocen estas señales neuronales y hormonales y según su

intensidad emiten respuestas convenientes para la fase del día o la noche (como

se puede ver en la figura 1). Para la adecuada sincronización del sistema

circadiano se requiere que las señales de luz-oscuridad que recibe el reloj

biológico concuerden con las señales que recibe del resto del cuerpo sobre las

actividades que realiza. Cuando estas señales están descoordinadas confunden al

sistema circadiano y lo llevan a perder el orden temporal, lo cual repercute en la

conducta y en la fisiología del individuo.

Hoy en día, nuestras casas, lugares de trabajo y calles están iluminadas por

luz artificial brillante durante el día y durante la noche. La exposición a la luz

artificial de noche provoca la pérdida de una alternancia del ciclo día-noche y

representa un factor de riesgo para la coordinación del reloj biológico. El mal

funcionamiento del sistema circadiano a largo plazo desencadena padecimientos

6

crónicos, entre ellos enfermedades metabólicas, cáncer y alteraciones del estado

de ánimo (Escobar et al., 2011).

Son varias las condiciones que pueden desencadenar alteraciones

circadianas, entre ellas, la más común es el trabajo nocturno, también el

síndrome de jet-lag resultante de los viajes trasmeridionales, el alimento y los

estímulos luminosos durante la noche. Existe amplia literatura que aborda la

relación de la alteración circadiana principalmente asociada con el trabajo

nocturno y el jet-lag. Sin embargo, los efectos de la exposición a la luz artificial

durante la noche sobre el sistema circadiano y la salud apenas comienzan a ser

estudiados.

Este artículo tiene como objetivo definir en qué consiste el problema de la

contaminación lumínica asociada a la luz artificial por la noche. Presentaremos

evidencias clínicas y experimentales que indican que la exposición a la luz por la

noche es un factor adverso, promotor de alteraciones circadianas y de problemas

de salud.

El problema de la contaminación lumínica: el exceso de luz por la

noche (St1)

La luz es esencial para la vida en la Tierra, es una fuente de energía, de calor, y

mantiene los niveles de oxígeno en la atmósfera debido al importante papel que

juega en la fotosíntesis.

Por miles de años el

hombre ha vivido en un

ambiente donde la luz

corresponde a la fase de

actividad y la noche a la

fase de descanso. A lo

largo de la historia, la

posibilidad de alumbrar la

noche dependió de la

flama tenue de una

hoguera o de una

antorcha y fue apenas

hace poco más de 100

años que Tomás Alba

Edison (1879) inventó la bombilla eléctrica y fue posible alumbrar la noche con una

mayor intensidad. El siglo XX se caracterizó por la implementación de luz eléctrica

en casas y sitios de trabajo, permitiendo extender las horas de trabajo y estudio a

la noche (Chepesiuk, 2009), lo cual modificó también el estilo de vida. Actualmente

en las ciudades y pueblos se abusa del uso de la luz por la noche, proceso que

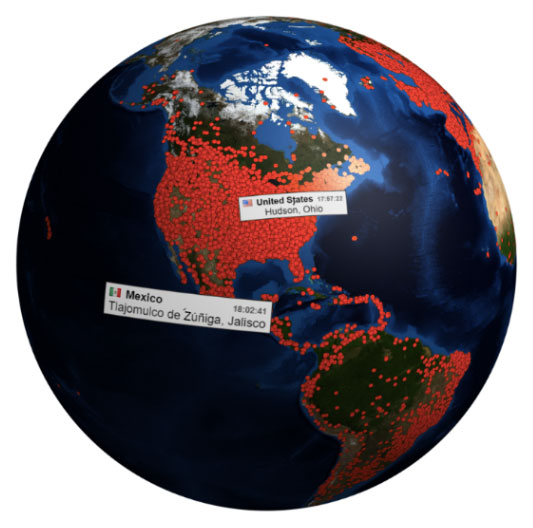

conocemos como “contaminación lumínica”. El abuso de iluminación es tal, que se

irradia a muchos kilómetros más allá de las ciudades, iluminando los campos, las

montañas y la naturaleza en general. Esta luz nocturna afecta patrones de

migración de algunas aves e insectos y en algunas especies altera los ritmos de

reproducción (Navara y Nelson, 2007). La iluminación urbana también produce

“invasión lumínica”, que ocurre cuando la luz del alumbrado público irradia hacia el

interior de las casas, ocasionando un nivel de luminosidad constante aun teniendo

las luces apagadas (Falchi, Cinzano, Elvidge, Keith y Haim, 2011). Otra fuente de

luz nocturna proviene de los aparatos electrónicos como pantallas de televisión,

computadoras, teléfonos celulares y tabletas, que irradian luz directamente a los

ojos del individuo que los está empleando (ver figura 2).

8

Figura 2. El teléfono celular es una fuente de luz nocturna, que irradia luz directamente a los ojos

del individuo que los está empleando. Foto: Vladyslav Dukhin.

¿Cuánto es mucha luz? (St1)

En un día soleado, la iluminación puede llegar a alcanzar hasta los 100,000 lux 2 ,

pero en un cuarto bien iluminado la intensidad de la luz alcanza los 1000 lux.

Preferentemente en la recámara en donde vamos a dormir y con la luz apagada, la

intensidad debiera ser menor a 10 lux.

Inicialmente los especialistas en ritmos circadianos consideraron como

dañina una intensidad de luz de 7 000 a 13 000 lux debido a que alteraba al reloj

biológico y con ello la expresión de los ritmos circadianos (Boivin, Duffy, Kronauer

y Czeisler, 1996). Sin embargo, tomando como referencia el ritmo diario de

melatonina, hormona que se secreta solamente por la noche y es inductora del

sueño, se determinó que intensidades de hasta 0.2 lux de luz blanca inhiben

inmediatamente su producción (Nathan, Burrows y Norman, 1999; Pauley, 2004).

2 Unidad estándar de medida de la intensidad de la luz.

9

Al respecto se ha determinado que la longitud de onda de 440 a 460 Hz que

corresponde a la luz azul, aún con intensidad baja de 1 lux, es suficiente para

suprimir la secreción de melatonina (Stevens, Brainard, Blask, Lockley y Motta,

2013). Es importante resaltar que las pantallas de televisión, de computadoras y

tabletas emiten principalmente longitudes de onda correspondientes al espectro

azul (Zeitzer, Dijk, Kronauer, Brown y Czeisler, 2000).

En fuentes de luz con un espectro más amplio de longitudes de onda (por

ejemplo, lámparas del alumbrado público) una intensidad de 100 lux tiene

el mismo efecto. Esta luz también modifica la actividad del NSQ el cual,

como ya se describió, utiliza como referencia temporal la alternancia día-

noche para sincronizar sus oscilaciones diarias y coordinar los ritmos

circadianos del organismo. Actualmente en la mayoría de las casas

durante la noche, las fuentes de luz emiten iluminación de hasta 1000 lux,

intensidad suficiente para retrasar el inicio del sueño, causar alteraciones

circadianas e inhibir la secreción de melatonina (Reiter, 2006).

Consecuencias de la luz por la noche: estudios clínicos (St2)

La luz por la noche promueve un estado de alerta conductual, que retrasa el inicio

del sueño y promueve al desvelo. En días de trabajo o escuela estos desvelos

tienen como consecuencia que se acorten las horas de descanso y ello ocasiona

una privación de sueño crónica, que afecta el rendimiento escolar y laboral (van

Cauter et al., 2007). Una preocupación actual es que en sujetos jóvenes, la

exposición a luz artificial durante la noche (5 a 10 lux) afecta la calidad del sueño,

aumenta la frecuencia de los despertares, la cantidad de sueño superficial y

disminuye la cantidad de movimientos oculares rápidos (Cho et al., 2016). En un

trabajo pionero de Lewy, Wehr, Goodwin, Newsome, y Markey (1980), se

exploraron los efectos de la exposición a diferentes intensidades de luz por la

noche en un rango de 0.03 hasta 9.5 lux y se observó que la exposición a todas

las intensidades de luz provoca a corto plazo efectos adversos sobre los ritmos

hormonales y de temperatura (Boivin et al.,1996). En un estudio más reciente se

reportó que, en personas jóvenes la exposición a la luz por la noche, con una

intensidad equivalente a la pantalla de una computadora, suprime la liberación de

melatonina (Gooley et al., 2011).

10

La noche en nuestro organismo (St3)

Actualmente un 30% de la población mundial trabaja por la noche (Rajaratnam y

Arendt, 2001) y esta es la población más expuesta a la luz nocturna. En

trabajadoras nocturnas se ha descrito una mayor propensión a desarrollar cáncer

de mama (He, Anand, Ebell, Vena y Robb, 2015) y se ha determinado que el

haber trabajado 15 años o más en turnos rotatorios o nocturnos incrementa hasta

un 28% el riesgo de padecer cáncer de pulmón en mujeres fumadoras

(Schernhammer, Feskanich, Liang y Han, 2013). En enfermeras que trabajaron

turnos nocturnos y estuvieron expuestas a la luz brillante mientras dormían, se

demostró que los niveles de melatonina eran menores en comparación con

enfermeras que trabajaron turnos diurnos (Grundy et al., 2009). Igualmente, entre

los trabajadores nocturnos masculinos hay mayor propensión a padecer cáncer de

próstata, además de presentar un mayor riesgo de eventos cardiovasculares con

riesgo de infarto (Sigurdardottir et al., 2012). El trabajador nocturno también tiene

mayor predisposición a la acumulación de adiposidad, sobrepeso y elevada

predisposición a desarrollar enfermedades metabólicas incluyendo diabetes

(Knutsson, 2003).

A nivel de la conducta, se ha reportado mayor propensión a cambios en

el estado de ánimo, caracterizados por mayor irritabilidad, fatiga y

dificultad para concentrarse, además de mayor vulnerabilidad a

desencadenar depresión (Edgar y McClung, 2013; Germain y Kupfer,

2008). En estos individuos también se ha reportado mayor vulnerabilidad

de incurrir en la ingestión de drogas y alcohol (Morikawa et al., 2013).

Es difícil discernir la contribución de la luz por la noche sobre la cantidad de

alteraciones que presenta el trabajador nocturno, ya que estos individuos además

de la contaminación lumínica, están expuestos a privación de sueño y alteraciones

circadianas, que por sí mismos son factores que desencadenan muchas de estas

alteraciones fisiológicas y de la conducta.

ENTRA GALERÍA FOTOGRÁFICA

11

(envío una serie de fotografías, incluir 6 imágenes)

Para lograr deslindar el efecto de la luz nocturna sobre el metabolismo, un

Para lograr deslindar el efecto de la luz nocturna sobre el metabolismo, un

estudio realizado con una población de la región de Nara, en Japón, comparó

personas que se exponían a bajos o nulos niveles de luz por la noche (menos de 3

lux) con personas que se exponían a niveles mayores de 3 lux (Obayashi et al.,

2013). El grupo que se exponía a mayor intensidad de luz presentó una mayor

incidencia de obesidad y alteraciones en los niveles de lípidos circulantes,

confirmando que la exposición a la luz por la noche desencadena disfunción

metabólica.

Un espacio para determinar los efectos nocivos de la luz por la noche, son

las unidades de cuidados intensivos en los hospitales, ya que en general éstas se

mantienen siempre con la luz prendida para permitir al personal médico y de

enfermería una supervisión eficiente de los pacientes. En un estudio realizado en

la unidad de terapia intensiva neonatal del Hospital Juárez de México, nuestro

grupo demostró que los bebés prematuros internados debido a bajo peso corporal

crecen y maduran más lentamente en condiciones de luz constante, en

comparación con los bebés prematuros expuestos a un ciclo de luz-oscuridad.

12

Para lograr esto, a algunos bebés se les colocó durante la noche un casco de

acrílico con una cubierta de tela que producía penumbra sobre su cabeza y ojos.

Comparados con bebés que no recibieron este tratamiento, a las tres semanas de

estancia en la unidad, los bebés expuestos a la oscuridad por la noche habían

ganado 150 g más de peso y el tiempo de estancia hospitalaria se redujo a la

mitad, siendo para este grupo un promedio de 30 días para ser dados de alta y

para el grupo testigo de 60 días (Vasquez-Ruiz et al., 2014). Otros estudios

realizados en diferentes unidades de terapia intensiva han reportado efectos

similares, demostrando que la oscuridad por la noche mejora la capacidad de los

bebés para asimilar el alimento y por lo mismo logran aumentar de peso para ser

dados de alta (Blackburn y Patteson, 1991; Rivkees, Mayes, Jacobs, y Gross,

2004). Estos hallazgos son un claro ejemplo de la importancia que tiene la

oscuridad nocturna desde los primeros días de vida.

d

wqdwqdqwdwqd

dqw

dwqd

qw

d

TITULO CON SEPARADOR

Lorem ipsum dolor sit amet, consectetur adipiscing elit. Ut elit tellus, luctus nec ullamcorper mattis, pulvinar dapibus leo. Aenean consequat elit a lorem elementum convallis. Sed pharetra enim tempus convallis sagittis. Phasellus lacus urna, malesuada in feugiat id, semper rutrum nisl. Nulla id bibendum enim. Vivamus fringilla lacus nibh, faucibus finibus dui facilisis eu. Quisque tristique libero non eros elementum volutpat.

Es posible propiciar el pensar desde la misma Universidad. Es decir, enseñar a pensar para valorar la vida. También es posible generar una nueva actitud de pensar que promueva el respeto por los principios y valores universales, si enseñamos de tal forma que orientemos hacia un proceso auténtico y autónomo de pensar, si dejamos de controlar excesivamente, si permitimos que el alumno pueda pensar por cuenta propia.

Es posible propiciar el pensar desde la misma Universidad. Es decir, enseñar a pensar para valorar la vida. También es posible generar una nueva actitud de pensar que promueva el respeto por los principios y valores universales, si enseñamos de tal forma que orientemos hacia un proceso auténtico y autónomo de pensar, si dejamos de controlar excesivamente, si permitimos que el alumno pueda pensar por cuenta propia.

Referencias (St1)

CLD Commission (2015). Manual del Candidato. Para diseñadores de iluminación arquitectónica en ejercicio. Chicago: Certified Lighting Designer, CLD. Recuperado de http://cld.global/CLD/media/media/CLD-Handbook-Edits- June-17_ES-ES.pdf.

DiLaura, D. (2006). A History of Light and Lighting. EE. UU.: Illuminating Engineering Society.

DiLaura, D., Houser, K., Mistrick, R. y Steffy, G. (2011). The Lighting Handbook. 10th Edition. Nueva York, EE. UU.: Illuminating Engineering Society.

Donoff, E. (2006). Richard Kelly’s Three Tenets of Lighting Design. Architectural

Lighting, AL 30th Anniversary.

James, P. (2018). Editorial. Mondo ARC. ILDS, 18.

Kelly, R. (1952). College Art Journal. EE. UU.: College Art Association.

13

LIB Chaslin, F. (2017). La Conception Lumière. París, Francia: Moniteur.

Major, M., Speirs, J. y Tischhauser, A. (2005). Made of Light. Basel, Switzerland:

Birkhauser.

Haidar, J. (2006). Debate CEU-Rectoría. Torbellino pasional de los argumentos.

México: UNAM. Recuperado de

http://www.posgrado.unam.mx/publicaciones/ant_col-

posg/31_Debate_CEU.pdf

Pedroza, M. (2010). Identidades urbanas de taggers y graffiteros: análisis

transdisciplinario de la producción semiótica del graffiti en el Distrito

Federal. D.F., México: ENAH/INAH. Recuperado de

https://www.academia.edu/35991973/Identidades_Urbanas_de_Taggers_y_

Graffiteros_An%C3%A1lisis_transdisciplinario_de_la_producci%C3%B3n_s

emi%C3%B3tica_del_graffiti_en_el_Distrito_Federal

Pedroza, M. (2012). Semiosis visual en el graffiti de escritores: Producción cultural

urbana alternativa. D.F., México: ENAH/INAH. Recuperado de

https://www.academia.edu/35992064/Semiosis_visual_en_el_graffiti_de_es

critores_Produccion_cultural_urbana_alternativa

Pedroza, M. (2016). La unitas multiplex del graffiti planetario: cultura urbana

alternativa Ciudad de México, México: ENAH/INAH.

Pedroza, M. (2016). Pixação: protesta y transgresión . Discurso & Sociedad , 10

(2), 300-320. Recuperado de

http://www.dissoc.org/ediciones/v10n02/DS10(2)Pedroza.pdf

Fecha de recepción: 12/12/12 Fecha de aceptación: 12/12/12