Vol. 21, núm. 1 enero-febrero 2020

Robótica y ética: una entrevista al Dr. Ronald C. Arkin

Guadalupe Vadillo Bueno, Jackeline Bucio García, Ana María Romero, Karina Lizbeth Guerrero y Joaquín Navarro CitaResumen

Este artículo sintetiza una entrevista con el Dr. Ronald C. Arkin, conducida por el equipo del Bachillerato a distancia de la unam (B@unam). A lo largo de la entrevista se discuten diversas temáticas importantes relativas a los robots: robótica y ética, su carencia de agencia moral y libre albedrío, robots diseñados para uso militar, la intimidad que los humanos comienzan a tener con ellos y las regulaciones para su uso. También se considera si los robots deben tener derechos.

Palabras clave: robótica, roboética, guerra, engaño de las máquinas, robótica íntima, agencia moral.

Robotics and ethics

Abstract

This article presents a summary of an interview with Dr. Ronald C. Arkin, by the staff of unam‘s Virtual High School (B@unam). Along the interview, several important issues dealing with robots were discussed: robotics and ethics, their lack of moral agency and free will, robots designed for military use, the intimacy that humans are beginning to have with them, and regulations for their use. We also discussed if robots should be granted rights.

Keywords: robotics, roboethics, war, machine deception, intimate robotics, moral agency.

Introducción

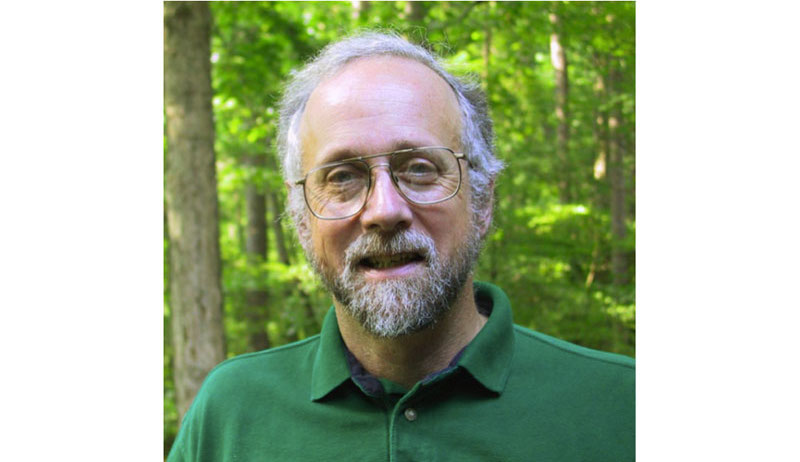

Hablar sobre robótica y ética resulta interesante y de gran relevancia. Tener la oportunidad de conversar con un experto reconocido mundialmente es una experiencia emocionante. Esto es justo lo que se vivió en la entrevista al Dr. Ronald C. Arkin, de parte del colectivo de académicos, investigadores, tecnólogos y diseñadores del Bachillerato a distancia de la Universidad Nacional Autónoma de México (unam), B@unam. El Dr. Arkin es Profesor Regent en la Facultad de cómputo del Georgia Institute of Technology, así como director del Laboratorio de robots móviles de dicha entidad (ver imagen 1).

Imagen 1. Dr. Ronald C. Arkin (Arkin, 2001).

Su investigación está enfocada a la percepción y control multiagente, en el contexto de robótica y visión computacional. Tres de sus más recientes publicaciones muestran algunos de sus intereses: “Robótica urbana: lograr autonomía en el diseño y regulación de robots y ciudades” (Woo, Whittington y Arkin, 2018), “Adaptación a las dinámicas ambientales con un sistema circadiano artificial” (O’Brien y Arkin, 2019) y “Ética del engaño en robots” (Arkin, 2018).1 Entre muchos proyectos de investigación, ha explorado el diseño guiado etológicamente de controladores robóticos con base en el bajo consumo de energía de perezosos y loris perezosos, lo que tiene implicaciones para el diseño de slowbots, robots móviles con ahorro de energía (Velayudhan y Arkin, 2017). También ha conducido investigación en el campo de los modelos de engaño y no cooperación usados en robots para, por ejemplo, confundir al enemigo (Nijholt et al., 2012). El Dr. Arkin ha investigado sobre asuntos éticos intrincados, como el desarrollo de compañeros robóticos capaces de influir en la conducta (Borenstein y Arkin, 2016).

A continuación presentamos una síntesis de la conversación que tuvimos con el Dr. Arkin a lo largo de una tarde de agosto, cuando visitaba México para participar en un congreso dentro de la unam.

¿Dónde comienza la historia de los robots?

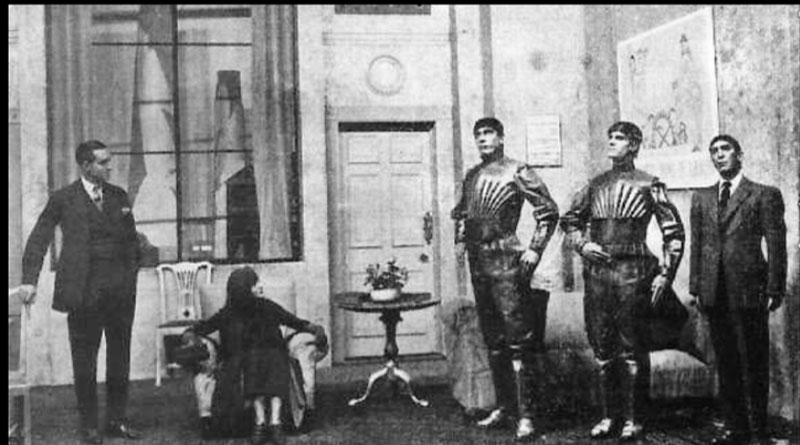

El Dr. Arkin inició la plática explicando que la primera mención sobre robots apareció en una obra de teatro del escritor checo Karel Čapek: Rossum’s Universal Robots (ver imagen 2). Más tarde, Isaac Asimov en las décadas de los cincuenta o sesenta introdujo el término robótica, así como sus leyes: no dañes a un ser humano; haz lo que los seres humanos te indiquen; y protégete. Los robots empezaron a crecer, por ejemplo, en las áreas manufactureras. Después, su uso se extendió a los hogares a través aparatos como las aspiradoras tipo Roomba. El ejército de Estados Unidos también ha estado usando robots. En China, se utilizan para cuidar niños: en las escuelas, revisan quiénes están enfermos y los canalizan hacia otras áreas.

Imagen 2. Escena de Rossum’s Universal Robots (A scene from R.U.R., showing three robots, 2006).

Si bien existen diferentes definiciones, para el Dr. Arkin los robots deben tener un cuerpo físico. Señala que algunos no son realmente inteligentes, como los que se usan en las fábricas: “se trata más de esclavos que repiten los mismos movimientos miles si no es que millones de veces al día”.

La relación entre ética y robótica

Los robots, comenta el Dr. Arkin, implican preocupaciones éticas y cada persona tiene una distinta perspectiva al respecto. Sin embargo, destacan dos cuestiones. Una es el uso militar, en especial, las armas letales autónomas, que han sido discutidas en la Organización de las Naciones Unidas (onu) por seis años. Las conversaciones no han llegado muy lejos debido a que no existe un acuerdo sobre los términos involucrados. Diversas agencias han llamado a una prohibición de esos tipos de armas, y hay entre siete y ocho países que no la apoyan, aunque todos promueven la discusión sobre el tema. La ley humanitaria internacional está basada en los convenios de Ginebra; el asunto relevante es valorar si los robots para uso militar cumplen con ella y si no lo hacen, qué necesitamos cambiar, en tanto que la regulación de la tecnología es importante para proteger la vida: debemos salvar a las personas inocentes que pueden ser asesinadas en el campo de batalla.

La segunda cuestión es lo que llama robótica de internet. Los robots se vuelven más íntimos; hoy podemos ver que la gente tiene discusiones con su teléfono. Los robots tienen el potencial para involucrarse en relaciones cada vez más cercanas con los seres humanos. Pueden ayudar a incorporar a niños con autismo a la sociedad, por ejemplo. En este caso, los robots sirven como peldaños para que los chicos se relacionen mejor con seres humanos. Por otro lado, no tenemos que preocuparnos por los robots sexuales: la gente ha usado juguetes y artefactos sexuales desde el principio de la humanidad, ya sea con piedras, palos u otros objetos. El riesgo es atribuirles agencia, empezar a preocuparse por ellos al tiempo de dañar relaciones humanas, aunque muy pocos hablan de ello. Existen diversas preguntas que podemos plantearnos: en caso de que una persona se involucre en relaciones íntimas con un robot, ¿se trata de adulterio?, ¿de bestialidad? ¿Podría casarse con un robot? No tenemos respuesta a estas preguntas, pero debemos tener estas conversaciones y alejarnos de la vergüenza que con frecuencia el tema provoca. Existe un mercado importante para este tipo de máquinas, incluso si sólo se trata de la centésima parte del uno por ciento de la gente: esa cifra es aún muy grande.

Imagen 3. El río Whanganui en la isla norte de Nueva Zelanda (Shook, 2005).

Las respuestas a cuestiones de orden ético obedecen a diferentes factores. Por ejemplo, cuando uno pregunta sobre el aborto o la pena capital, ¿cuál es la respuesta correcta? Depende de a quién se le plantee, en qué año, cuál es su religión… Así, distintos marcos y diferentes culturas conducirán a una variedad de respuestas. Ello nos dirige hacia la agencia moral y los derechos de los robots. La gente tiene agencia moral y es responsable de sus acciones. Cada persona tiene libre albedrío, o al menos eso piensa, para poder realizar sus elecciones y ser responsable de ellas. Los robots no lo tienen y probablemente carezcan de ello por mucho tiempo. Por esa razón, el Dr. Arkin considera que los robots aún no deben tener derechos. Sin embargo, los derechos pueden atribuírseles: por ejemplo, hay un video de un robot P.N., un robot dinosaurio, que está siendo golpeado y torturado. Empieza a retorcerse y a emitir chillidos, lo que lleva al espectador a sentirse incómodo, aunque en realidad el robot no está sintiendo nada. La cuestión es: ¿se está maltratando al robot en esas circunstancias? Para Arkin, el asunto relevante es el impacto que tiene en la persona que lleva a cabo la acción, más que el robot en sí mismo. Si una persona piensa que está afectando los derechos y concluye que eso está bien y luego traslada esta situación a los seres humanos, resulta potencialmente problemático. Por otro lado, el Dr. Arkin no desea que los robots sean esclavos ya que esto pudiera tener como consecuencia regresar a la percepción que la humanidad tenía hace mucho tiempo sobre la esclavitud, lo cual, evidentemente, no es deseable.

Imagen 4. Sophia, la primera robot con ciudadanía (ITU Pictures, 2018).

Se trata de lo que los derechos buscan lograr, indica. Por ejemplo, existe un río en Nueva Zelanda que tiene derechos (ver imagen 3). La sociedad quiere protegerlo para combatir la contaminación. En otro orden de cosas, hay un robot al que se le concedió la ciudadanía en Arabia Saudita (ver imagen 4). Tiene los derechos que las mujeres en ese país no tienen. ¿Debemos hacer un juicio moral sobre ello? ¿Quién es la persona adecuada para decidirlo?

Otros usos de los robots

Existen algunos usos terapéuticos de los robots en casas de retiro, de tal forma que, si los padres o abuelos de una persona se encuentran en uno de estos hogares y le cuesta trabajo visitarlos, puede comprarles un robot. También hay uno que se usa con criminales, niños afectados o pacientes de la tercera edad que sufren de demencia o delirio severo. Esos robots aportan confort y actúan como mascotas o facilitadores sociales. Se ha demostrado que pueden reducir el estrés. El Dr. Arkin trabajó con hydro Sony, un perro-robot que recién se lanzó. Su propósito es ser un robot de compañía y ha sido muy exitoso, aunque resulta algo caro. En este sentido hay dos cuestiones importantes: su confiabilidad y su seguridad. Los robots no deben ser arreglados cada semana o cada mes, de la misma forma que uno espera no tener que llevar a su pareja frecuentemente al doctor. Uno quiere ser un acompañante, no un cuidador. En el caso de los robots, queremos que nos cuiden, no tenerlos que cuidar nosotros. En cuanto a seguridad, los robots de compañía nunca deben, desde luego, causar daño a los usuarios.

¿Qué hay de la guerra?

“Cuando nos preguntamos qué gana o qué pierde la humanidad al usar robots en las guerras, la respuesta más simple es: la humanidad no gana nada en la guerra. Punto”. El Dr. Arkin continúa diciendo que, desgraciadamente, la guerra ha persistido desde el principio de los tiempos. Son hechos establecidos que la gente se va a matar entre sí y que hay una forma de hacerlo, de ahí que se establecieran los convenios de Ginebra. Las revoluciones en los asuntos militares cambian la forma en que las guerras se conducen. Algunos ejemplos son los buques de guerra y los portaaviones. Los robots también cambiarán la forma en que peleamos (ver imagen 5).

Imagen 5. UGV talon Gen. IV (Swadim, 2018).

Los sistemas robóticos pueden prevenir pérdidas y daño colateral en general, si se usan de manera apropiada, en circunstancias específicas y equilibradas, y si se desarrollan y se lanzan al campo de batalla con cuidado y efectividad. Bajo esas condiciones, pueden aportar valor humanitario. En otras situaciones, sólo contamos con un arma más que contribuye al caos en dicho campo de batalla. Por ello, deben regularse: existe una necesidad de manejar controles de forma que quienes no combaten estén seguros. Hoy en día dichas personas mueren más que los combatientes, aunque tenemos la tecnología para reducir esos números. Existe el imperativo moral de lanzar esta tecnología para dicho fin.

La forma en que hemos manejado el pasado es a partir de la creación de leyes y regulaciones adecuadas, y de la criminalización de ciertos tipos de actividades. Sólo ha habido una prohibición preventiva proactiva. Se trata de los láseres que ciegan a las personas. Todos estaban de acuerdo en prohibirlos. ¿Por qué? ¿Qué sucede con esos soldados cuando regresan a casa? Hay que cuidarlos. Uno se pregunta si las naciones prefieren que se le dispare a una persona en los ojos antes que sólo cegarlos.

Los convenios de Ginebra incluyen la cláusula de mercado que nunca se ha utilizado, pero que establece que si un sistema de armas viola el dictado de la “conciencia pública” será prohibido. El problema es que nadie sabe cómo medir la conciencia pública de manera efectiva. El Dr. Arkin preferiría apoyar una moratoria, lo que significa: “no lo prohibamos aún, no lo lancemos en este momento, y quizá encontremos formas de utilizarlo en el futuro”. Considera que es más conveniente decidir si un sistema en particular o una misión en específico es aceptable. Si no lo es, debemos preguntarnos qué requiere para que pueda serlo o si debe prohibirse.

¿Y después?

Para terminar, el Dr. Arkin indicó que la gente se está haciendo más responsable. “Cuando comencé hablando de robótica en 2003 o 2004, quizá había una docena de personas interesadas en estas cuestiones. Ahora contamos con la asociación profesional más grande, de alrededor de 40 mil miembros, en las áreas de computación e ingeniería electrónica. Aportaron las Iniciativas globales de ieee sobre ética de sistemas inteligentes y autónomos.2 Representa un esfuerzo para encontrar formas en que unamos las voces”.

Referencias

- A scene from R.U.R., showing three robots (2006). Recuperado de: https://commons.wikimedia.org/wiki/File:Capek_play.jpg.

- Arkin, R. C. (2001). Ronald C. Arkin [American professor of robotics]. Recuperado de: https://commons.wikimedia.org/wiki/File:Ronald_C._Arkin.jpg.

- Arkin, R. C. (2018). Ethics of robotic deception. ieee Technology and Society Magazine, 37(3).

- Borenstein, J. y Arkin, R.C. (2016). Nudging for good: robots and the ethical appropriateness of nurturing empathy and charitable behavior. ai & Society, 32(4). doi: https://doi.org/10.1007/s00146-016-0684-1.

- itu Pictures (2018). Sophia, la primera robot con ciudadanía. Recuperado de: https://www.flickr.com/photos/itupictures/27254369347/.

- Nijholt, A. et al. (2012). Trends & controversies. ieee Intelligent Systems, 27(6), 60-75, doi: https://doi.org/10.1109/MIS.2012.116.

- O’Brien, M. y Arkin, R. C. (2019). Adapting to Environmental Dynamics with an Artificial Circadian System. Adaptive Behavior. doi: https://doi.org/10.1177/1059712319846854.

- Shook, J. (2005). Whanganui River. Recuperado de: http://en.wikipedia.org/wiki/Image:Whanganui_River.jpg.

- Swadim (2018). ugv talon Gen. iv. Future Forces Forum 2018. Recuperado de: https://commons.wikimedia.org/wiki/File:UGV_TALON.jpg.

- Velayudhan, L. y Arkin, R. C. (2017). Sloth and slow loris inspired behavioral controller for a robotic agent. ieee International Conference on Robotics and Biomimetics (robio), Macau, 1880-1885. doi: https://doi.org/10.1109/ROBIO.2017.8324693.

- Woo, J., Whittington, J. y Arkin, R. C. (2018). Urban robotics: Achieving autonomy in design and regulation of robots and cities. Social Science Research Network (ssrn). doi: https://doi.org/10.2139/ssrn.3145460 [aparecerá en el Connecticut Law Review, 52].

Recepción: 09/12/2019. Aprobación: 13/12/2019.