Vol. 21, núm. 1 enero-febrero 2020

Mentes en la orilla: presente y futuro de la inteligencia artificial

Rafael Morales Gamboa CitaResumen

En este texto se hace una revisión del libro Possible Minds: Twenty-Five Ways of Looking at ai, editado por John Brockman y publicado en 2019, en celebración de los cincuenta años de la publicación de Cybernetics: Or Control and Communication in the Animal and the Machine, con el cual Robert Wiener fundó la cibernética en 1948. Si bien la inteligencia artificial (ia) y la cibernética han caminado senderos distintos y con pocos cruces, hoy en día éstos parecen coincidir en el potencial de su desarrollo para transformar de manera radical las condiciones de vida y naturaleza de la especie humana.

Palabras clave: inteligencia artificial, aprendizaje profundo, inteligencia general, superinteligencia, cibernética, física, teoría de sistemas.

Possible minds: the present and future of artificial intelligence

Abstract

In this paper we present a review of the book Possible Minds: Twenty-Five Ways of Looking at ai, edited by John Brockman, and published in 2019 in celebration of the fiftieth anniversary of the publication of Cybernetics: Or Control and Communication in the Animal and the Machine, by which Robert Wiener founded cybernetics in 1948. Although artificial intelligence (ai) and cybernetics have walked different paths with only few crosses, today they seem to coincide in their development’s potential to radically transform nature and human’s living conditions.

Keywords: artificial intelligence, deep learning, general intelligence, superintelligence, cybernetics, physics, systems theory.

Introducción

Alrededor de 1950, la sobrevivencia de la especie humana parecía pender de un hilo. El desarrollo de la física a principios de siglo había conducido a la creación de armas nucleares cuya capacidad de destrucción masiva crecía con los años. Al mismo tiempo, los ojos de la sociedad se abrían hacia modernas áreas de conocimiento y nuevas expectativas. La biología consolidaba sus bases (Huxley, 1942) e intentaba desafanarse de la amenaza de ser reducida a una extensión de la física y la química. Al mismo tiempo, se buscaba una solución al problema de la aparente violación de la segunda ley de la termodinámica de parte de los seres vivos. Dicho principio establece que el universo tiende a la pérdida de su complejidad, mientras que los seres vivos y su evolución parecen incrementarla (Brillouin, 1949). De esta manera, se estimuló la creación de la Teoría general de sistemas por Ludwig von Bertalanffy y colaboradores (1968/1976) que, a su vez, serviría de inspiración al sociólogo Talcott Parson, que publicaría su teoría de los Sistemas Sociales en 1951. Las famosas Conferencias Macy (Wikipedia contributors, 2019) sirvieron de caldo de cultivo para nuevas disciplinas. Entre ellas estaba la cibernética, definida por su fundador Norbert Wiener como “el campo completo de la teoría del control y la comunicación en las máquinas y los animales” (Wiener, 1948/1961, p. 11); la cual vino a ser un parteaguas por su papel en la comprensión de lo biológico y por las expectativas que generó sobre la creación de entes artificiales con funcionamientos similares.

Dos años después, consciente del desarrollo acelerado de la cibernética, Wiener expresa sus preocupaciones acerca del control de los seres humanos por los seres humanos (Wiener, 1950) e influye en John von Neumann, de tal modo que éste llega a predecir que en veinte años tendría lugar la singularidad tecnológica, entendida como el momento histórico en que el desarrollo de las tecnologías cibernéticas y digitales conduciría a la creación de seres más avanzados que nosotros mismos (Wilczek, 2019).

Setenta años después de la publicación del libro Cybernetics: Or Control and Communication in the Animal and the Machine (Wiener, 1948/1961), ha resurgido en los medios el interés por la ia como consecuencia de sus victorias recientes, obtenidas gracias al cumplimiento de la Ley de Moore (1965) en el desarrollo de la tecnología digital, lo que ha permitido la implementación de nuevas técnicas de ia. Por otra parte, el inventor Ray Kurzweil ha predicho que la singularidad tecnológica ocurrirá en la primera mitad de este siglo (Kurzweil, 2006), en tanto que otras figuras públicas como Stephen Hawkins y Elon Musk han advertido sobre el peligro que para la especie humana conlleva el desarrollo acelerado y desmedido de las tecnologías digitales.

En este sentido, John Brockman percibe el cumplimiento de un ciclo tecnológico y el comienzo de una nueva era, cuyas características son difíciles de imaginar. Convoca a veinticinco expertos en áreas diversas, desde física y ciencias computacionales hasta historia de las ciencias, arte, biología, filosofía y psicología, a expresar sus visiones sobre del estado actual y futuro de la ia, así como su impacto en la sociedad y la humanidad en general, y las integra en el libro Possible Minds: Twenty-Five Ways of Looking at ai (Brockman, 2019). La multidisciplinariedad de los autores, así como los esfuerzos hacia la interdisciplinariedad de varios de ellos, ofrece una visión compleja de la ia en su contexto histórico y social que es poco común, la cual se presenta a continuación dividida en cuatro grandes áreas: la invasión digital en nuestras vidas, el estado actual de la ia y su impacto social, la prospectiva de futuro de la misma, sus implicaciones para la humanidad y los problemas de fondo que conlleva.

La invasión digital

Para Rodney Brooks (2019) la cibernética representó el cierre de la era de las máquinas físicas. Si bien ha revolucionado la industria, como consecuencia de los avances tecnológicos en el control automático, las tecnologías digitales han ido permeando los distintos aspectos de nuestra cotidianidad y están inmiscuidas en prácticamente todas nuestras actividades, transformando nuestras vidas al punto de generar temores de “deshumanización” como consecuencia de nuestra dependencia a lo digital y las modificaciones en nuestros comportamientos.

En el caso de la ia, Venki Ramakrishnan (2019) resalta su impacto profundo en el ámbito laboral, como ha sucedido en las revoluciones industriales de otras épocas. Estudios en Estados Unidos (Hicks y Devaraj, 2017) e Inglaterra (Office for National Statistics, 2019) han hecho evidente la pérdida de empleos como consecuencia de la automatización y de la incorporación de la ia en procesos de producción de “cuello azul”, ejemplo de ello son las líneas de producción automotrices, ampliamente robotizadas, aunque también se da en procesos de cuello blanco, como la venta de productos y la contabilidad de las empresas. Para Ramakrishnan, mucha gente perderá empleos si la optimización de procesos por la ia se acelera en el corto plazo.

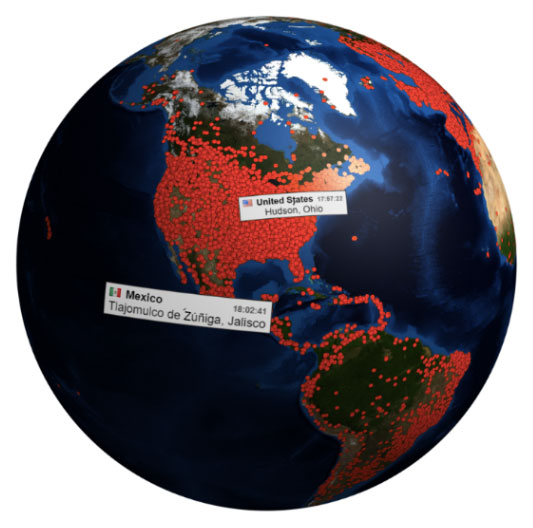

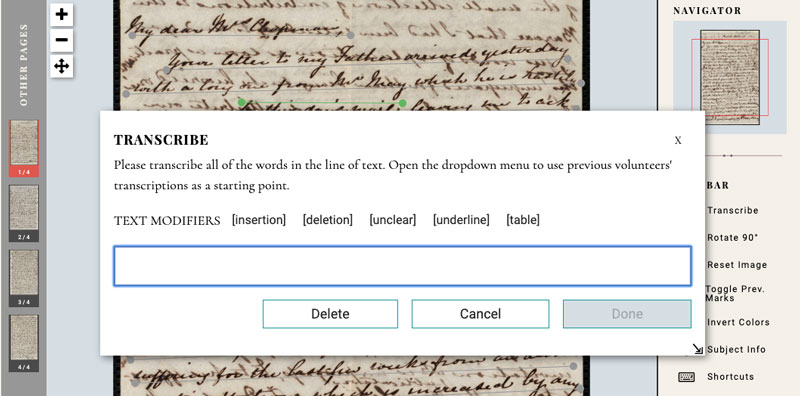

De acuerdo con Alex “Sandy” Pentland (2019), una de las consecuencias más importantes del uso de las tecnologías digitales en nuestra vida es la pérdida de la privacidad, dado que vamos dejando huellas digitales que pueden ser analizadas y usadas por las grandes empresas de tecnología digital que han emergido sobre la base de la nueva materia prima: información. Brooks (2019) alerta sobre el problema de la inseguridad del software existente y la falta de metodologías que garanticen la confiabilidad del software inteligente del futuro, lo cual considera particularmente riesgoso para la humanidad.

En este sentido, Daniel C. Dennett (2019) trae a colación la capacidad que tenemos los seres humanos para identificar intenciones en los comportamientos de otras personas. Comenta que el abuso de la misma nos lleva a atribuir personalidad a seres o dispositivos que exhiben comportamientos similares a los nuestros, lo cual representa un riesgo cuando les confiamos decisiones que no están capacitados para tomar –como dejar el control total de un automóvil a un piloto automático, incluso en condiciones de alto riesgo (Bogost, 2018)–. Dennett propone regulaciones estrictas, garantías sobre la operación del software y penalizaciones severas para quienes no las cumplan, antes de poner este tipo de sistemas en las manos de sus usuarios.

Una generalización del problema de la falta de seguridad del software, planteada por Brooks y Caroline A. Jones (2019), es que la tecnología está sesgada por la cultura que la produce y su contexto histórico, lo cual llega a tener un efecto negativo importante sobre algunos segmentos de la población. Las implicaciones culturales más profundas son más difíciles de observar y suelen pasarnos desapercibidas, razón por la cual Jones hace énfasis en la sensibilidad del artista para observar estos sesgos.

La inteligencia artificial hoy

Antes de presentar lo que los autores del libro Possible Minds escriben sobre el estado actual de la ia, es necesario introducir algunas distinciones y sus términos. Inteligencia general hace referencia a la “inteligencia común” en los seres humanos, la cual nos permite comunicarnos en lenguaje natural, utilizar herramientas para lograr objetivos, planificar nuestras acciones, socializar con otras personas y animales y, como comenta Seth Lloyd (2019), amarrar las agujetas de nuestros zapatos. Por analogía, se entiende por inteligencia artificial general como aquella producida por medios no biológicos, pero que exhibe capacidades similares a las humanas, particularmente en el ámbito cognitivo (Adams et al., 2012). Otro término usado con frecuencia en relación a este concepto es el de ia fuerte (strong ai), en referencia a la rama de la ia que busca entender la inteligencia general natural mediante el desarrollo de su contraparte artificial, en tanto que el término ia débil (weak ai) es usado para describir investigaciones y desarrollos de ia con objetivos y en ámbitos mucho más específicos, como la solución de problemas concretos .

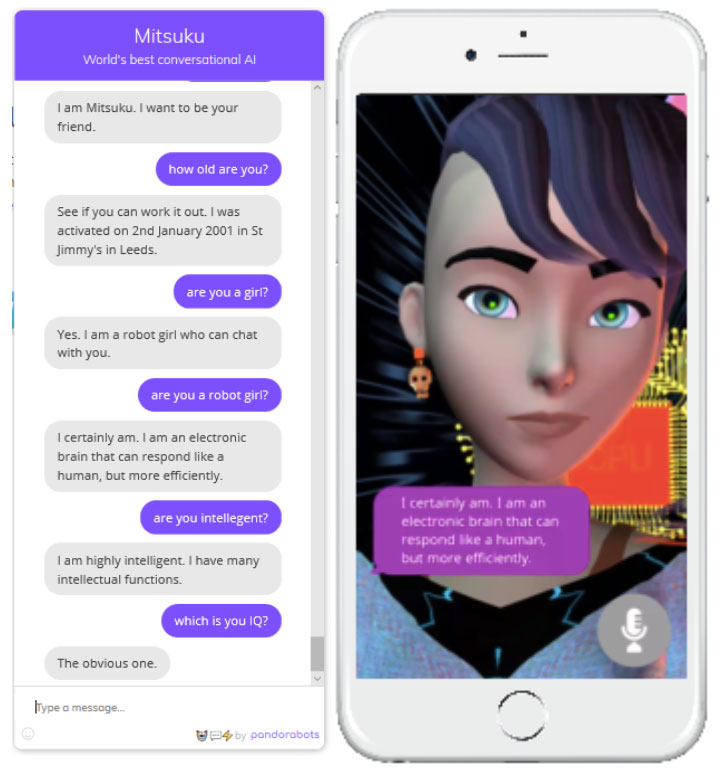

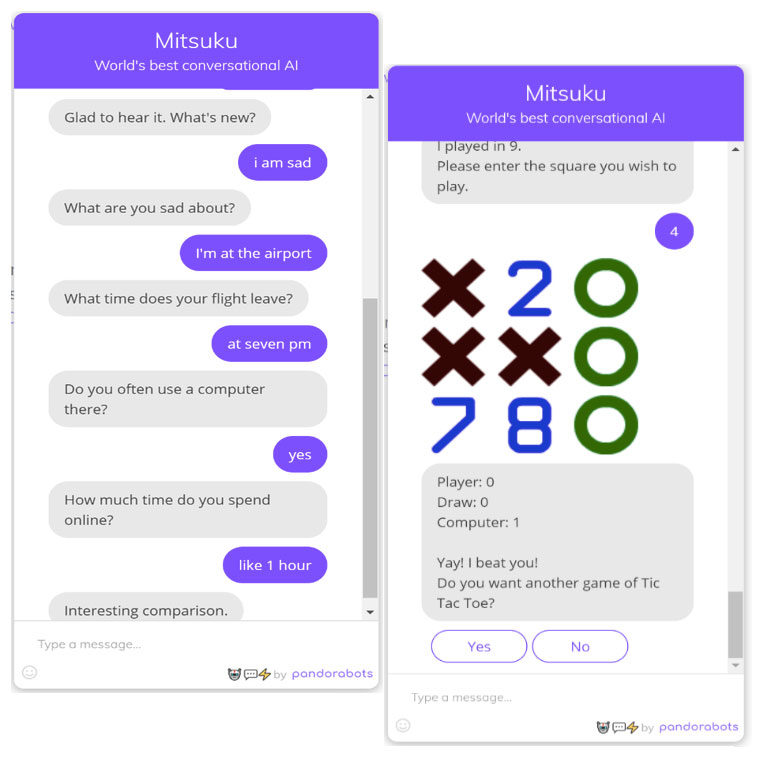

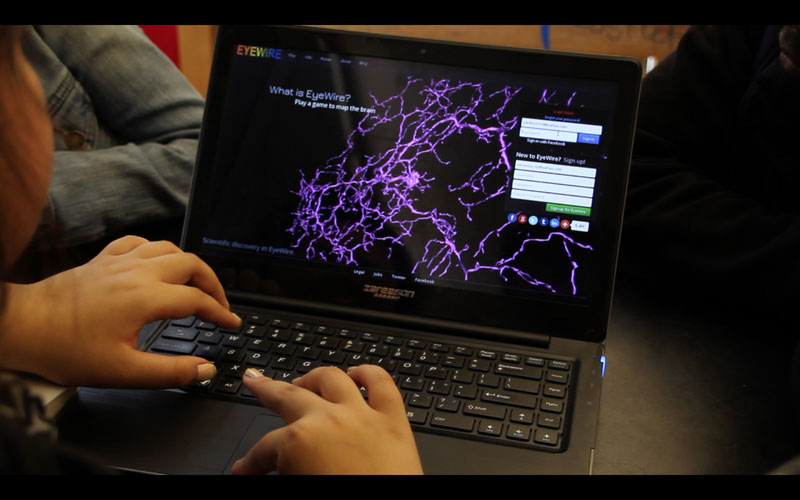

Muchos investigadores en el campo de la ia no están interesados en entender y desarrollar inteligencia general. David Deutsch (2019) comenta que los resultados de la ia que más brillan actualmente, como el vencimiento de campeones mundiales en ajedrez y Go, y las aplicaciones que se comunican con nosotros en lenguaje natural, están muy lejos de una ia general y, de hecho, no han sido desarrollados en esa dirección. Ejemplo de ello es el aprendizaje profundo (deep learning) (Goodfellow et al., 2016), capaz de vencer al campeón del juego de mesa más difícil del mundo y, al mismo tiempo, incapaz de explicar cómo lo hace o de transferir lo aprendido para jugar gato (tres en línea). De acuerdo con Judea Pearl (2019), la optimización que se logra con este tipo de métodos es equivalente a la que se obtiene por selección natural: requiere grandes cantidades de información, optimiza para una situación particular y su desarrollo es lento en comparación con las capacidades de los seres humanos de modelar el entorno y el comportamiento de otros seres. Para Alison Gopnik (2019) un niño de cuatro años aprende mejor y es más inteligente que la ia más moderna1.

La técnica de aprendizaje profundo genera su conocimiento a partir del procesamiento de una enorme cantidad de datos sobre un tema específico; identifica patrones y los codifica en las conexiones de redes neuronales. Con los datos correctos, en cantidad y cobertura, la técnica de aprendizaje profundo puede generar un experto en resolver un problema difícil en unos cuantos meses. Sin embargo, Lloyd (2019) considera que la “capacidad bruta de procesamiento de datos”, como en el aprendizaje profundo, no es lo mismo que una “capacidad sofisticada de procesamiento de información”, como en lo seres humanos, en tanto que Pearl (2019) pone el dedo en la incapacidad de este tipo de sistemas de realizar procesos cognitivos más complejos, como atender situaciones hipotéticas y razonar sobre sus propias acciones, así como en su naturaleza de “caja negra”, ya que somos incapaces de acceder al conocimiento generado por este tipo de “métodos opacos”.

A su vez, Steven Pinker (2019) señala como limitación de la ia su incapacidad de tener deseos que guíen sus comportamientos (por ejemplo, deseos de lograr una meta). Finalmente, Peter Galison (2019) desde la perspectiva de la historia de la ciencia y la relación entre el juicio de expertos humanos y los procedimientos (algoritmos) estandarizados, comenta sobre el problema que representa el hecho de que los algoritmos no sean transparentes, ya sea por su naturaleza (como en el caso del aprendizaje profundo) o por restricciones de derechos comerciales; problema que es particularmente agudo en ámbitos donde los derechos humanos están en riesgo, como la aplicación de justicia (Milgram, 2013).

En contraste con las posturas arriba mencionadas, existen otras en Possible Minds que cuestionan al ser humano como modelo de inteligencia y ofrecen perspectivas alternas sobre el estado actual de la ia. Para Neil Gershenfeld (2019), hay una fuerte relación entre los desarrollos más recientes en el área y lo que podría denominarse inteligencia biológica: ambas operan, no razonan. El código genético no se puede leer como la descripción del diseño de un ser vivo, o una explicación de por qué es como es y por qué funciona; simplemente logra producirlo –una especie de lenguaje operativo sin razonamiento, sin lógica, al estilo de las Leyes de la forma de George Spencer Brown (1969/1972)–. La opacidad de este tipo de representación de conocimiento, genética o en redes neuronales, no es problema para Ramakrishnan (2019), quien observa parcialidad en los argumentos en contra, considerando que tenemos poca idea de cómo procesa la información nuestro cerebro sin que ello afecte nuestra confianza en él mismo.

Una generalización interesante de las posturas anteriores la ofrece George Dyson (2019), desde una perspectiva de sistemas complejos. Dyson argumenta que un sistema inteligente es necesariamente complejo y, consecuentemente, incomprensible en su totalidad, y enuncia lo que llama las Tres leyes de la ia –que no se deben confundir con las Tres leyes de la robótica de Isaac Asimov (1950)–:

- Todo sistema de control, para ser efectivo, debe ser por lo menos tan complejo como lo que intenta controlar (W. Ross Ashby).

- Un sistema complejo se caracteriza por ser él mismo la descripción más simple de su comportamiento (John von Neumann).

- Un sistema suficientemente simple para ser comprendido no tiene la complejidad para comportarse inteligentemente, en tanto que un sistema con capacidad de comportarse inteligentemente es demasiado complejo para ser comprendido.

Sin embargo, incomprensibilidad desde las ciencias y las matemáticas no implica incomprensibilidad desde otras perspectivas. En ese sentido, Hans Ulrich Obrist (2019) ofrece el arte como medio para representar la complejidad de la operación de la ia y aborda cómo la ésta y la cibernética han servido de inspiración a algunos artistas, en tanto que otros las han usado para construir mundos artificiales.

El futuro

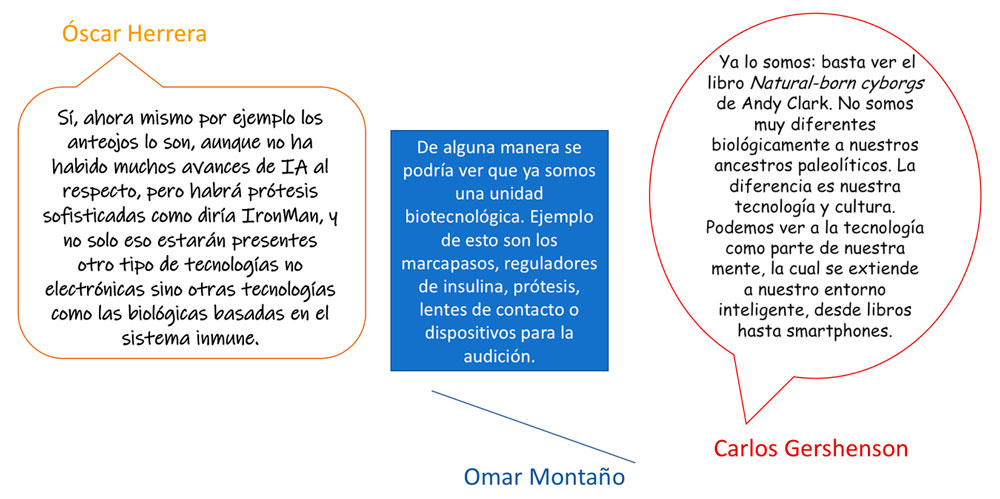

¿Qué podemos esperar de la ia? Para empezar, según Pentland (2019) hay una posibilidad de análisis de sistemas ultra complejos a partir de grandes cantidades de datos, enormes capacidades de cómputo y nuevas técnicas de análisis de redes. Ello debido en buena medida al crecimiento exponencial en información y conocimiento, así como en capacidad de procesamiento. Pero también, comenta Gershenfeld (2019), se debe a la automatización de los procesos de desarrollo de sistemas computacionales (o autoprogramación), que estamos observando ya en el caso de las redes neuronales. George M. Church (2019) compara las arquitecturas humanas y artificiales, y sugiere fusiones de la ia con las ingenierías genética y biológica que podrían añadir a los seres humanos capacidades no desarrolladas evolutivamente. Deutsch (2019) señala que los seres humanos, los ciborgs y las inteligencias artificiales van a tener a su disposición la misma tecnología, adaptable a los unos y los otros, dando lugar a una carrera evolutiva en la que sólo el mejor triunfará. Para Obrist (2019), el límite para la ia será el arte, donde tendrá, necesariamente, el rol menor de herramienta y no el de creador.

Otras miradas observan el futuro en dirección a la superinteligencia (Bostrom, 1998). W. Daniel Hillis (2019) concibe a las grandes organizaciones como “máquinas de carne y sangre”, con operación y comportamiento maquinal (Wiener, 1950), que incorporan las tecnologías digitales e ia para constituirse en superinteligencias híbridas, transnacionales, con agendas propias independientes de los individuos que las conforman y los países donde residen; que además ejercen un control distribuido mediante empoderamientos tecnológicos de dispositivos móviles, buscadores web, redes sociales, comunicaciones instantáneas y multimedia bajo demanda que inducen y regulan comportamiento (Dyson, 2019). Superinteligencias distintas de lo que imaginamos como tales, que nos dominan y, sin embargo, nos pasan desapercibidas.

En cualquier caso, advierte Stuart Russell (2019), no se puede asumir que una superinteligencia va a tener características similares a la nuestra ni que la podamos comprender. Dennett (2019) comenta que los sistemas artificiales superinteligentes serán probablemente muy diferentes a nosotros, difíciles de entender desde una perspectiva acostumbrada a encontrar pares en otros seres que se comportan de manera inteligente. Es el miedo a lo desconocido lo que nos lleva a preocuparnos de que un día nuestras creaciones sean mejores que nosotros y nos esclavicen. Como afirma Pinker (2019), gran parte de la ia se han modelado a partir de nuestra inteligencia natural y nuestro comportamiento pasado y actual; sin embargo, es importante tomar consciencia de que la evolución produce solamente optimizaciones locales, como los seres humanos, en tanto que la investigación en ia podría permitirnos explorar mejores opciones (Anderson, 2019). En este sentido, para Wilczek (2019), las diferencias entre la inteligencia humana y la artificial son diseños y tiempos de desarrollo: las ventajas de la primera son transitorias, en tanto que las ventajas de la segunda son permanentes.

Un libro que tiene como referente la creación de la cibernética no puede ser ajeno a una de las evoluciones teóricas más interesantes a partir de la misma: la perspectiva de los sistemas complejos. En este sentido, Obrist (2019) comenta que las grandes preguntas de la ia no son de implementación, sino filosóficas y que demandan una aproximación holística. Chris Anderson (2019) plantea la idea de la inteligencia como ingrediente natural del mundo físico y sugiere el método de descenso/ascenso del gradiente –bajar o subir por la vía más rápida– como método universal para la optimización en el mundo físico y candidato natural como origen de la inteligencia en el universo. Stephen Wolfram (2019) va un paso más allá y afirma que todo el universo y cada una de sus partes computan, no nada más los seres humanos y sus computadoras.

De acuerdo con Frank Wilczek (2019), no hay magia en la inteligencia humana: los seres humanos y los sistemas artificiales inteligentes son dos fenómenos emergentes distintos de la inteligencia a partir de la materia, cualitativamente diferentes en la manera en que se construyen, cuya mayor diferencia es que el proceso de construcción de los primeros inició hace miles de millones de años y se da por selección natural, en tanto que el proceso de construcción de los segundos lleva menos de cien años y es operado por el producto del primer proceso. Para Dennett (2019), somos robots hechos de robots (células), hechas de robots (moléculas), hechas de robots (átomos), hechos de robots. Max Tegmark (2019) comenta que el hecho de que el universo haya tomado conciencia de sí mismo a través de los seres humanos no implica que no la puede volver a tomar a partir de las creaciones de estos últimos. En consonancia, Church (2019) afirma que el mundo es tan complejo que es imposible decidir el futuro de la ia en el largo plazo, en tanto que David Kaiser (2019) hace énfasis en que, como sucede con la evolución natural, el progreso impone nuevas posibilidades, pero también nuevas restricciones.

Una postura diferente con respecto a la evolución de la ia es presentada por Jones (2019), quien comenta que la inteligencia es un fenómeno emergente a partir de la vida y considera que crear ia general implica necesariamente crear vida artificial: diseños que se reproduzcan a sí mismos es el desarrollo clave previo (Gershenfeld, 2019). Jones considera que ponerse como meta la inteligencia general sin estudiar fenómenos equivalentes a la vida, como lo hace la cibernética, es arrogancia.

A manera de cierre

Una primera conclusión que se deriva de lo expresado en Possible Minds es que la ia trae consigo una enorme transformación social de la que no todos, o relativamente pocos, serán beneficiados. Según Pinker (2019) la tecnología no es el problema, sino el uso de la misma motivado por ideas, normas y costumbres, que condicionan nuestro comportamiento. Para Tegmark (2019), la tecnología puede destruirnos por mal uso o por competencia. En todo caso, la ia es un producto cultural en su contexto histórico, lo cual hace necesario extender la mirada a los procesos de su creación.

A largo plazo, comenta Deutsch (2019), no es posible desarrollar una inteligencia artificial general pensando que será siempre amigable con nosotros, por lo que Dennett (2019) considera que el desarrollo de ia equivalente o superior a la nuestra no es deseable para los seres humanos. Anca Dragan (2019) señala que la alineación de valores para la toma de decisiones en contexto será crucial para la convivencia entre los seres humanos y seres con ia general. Griffiths (2019) comenta que será necesario que los seres con ia general nos comprendan, para lo cual necesitarán un buen modelo de nuestro comportamiento. De otra manera, tenderán a malinterpretarnos y las consecuencias pueden ser desastrosas.

Conclusiones

El libro de Norbert Wiener ofreció una teoría que explicaba tanto lo natural como lo artificial. Una de sus consecuencias, la Teoría de sistemas (Luhmann, 2013), nos baja de la cima de la creación del universo y nos ubica como desarrollo intermedio en una escala de sistemas complejos. Esta perspectiva se hace escuchar con frecuencia en el libro de Brockman, inspirado en la creación de la cibernética y el temor por su mal uso.

Ubicar a las inteligencias humana y artificial en un contexto universal, con orígenes comunes y desarrollos por procesos generales que parecen escapar de nuestras manos, implica que en cada ser con ia general habrá necesariamente una condición moral: deberá ser respetado y tener los mismos derechos que los seres humanos. Estamos programados para luchar por ser un estrato permanente en la evolución de los sistemas complejos (Tallinn, 2019), con valores que consideramos universales; pero es posible que la ia nos diga un día, tal vez cercano, que existen más y mejores opciones.

Referencias

- Adams, S., Arel, I., Bach, J., Coop, R., Furlan, R., Goertzel, B. y Sowa, J. (2012). Mapping the Landscape of Human-Level Artificial General Intelligence. ai Magazine, 33(1), 25-42.

- Anderson, C. (2019). Gradient Descent. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 143-150). Nueva York: Penguin Press.

- Asimov, I. (1950). I, Robot. Nueva York: Gnome Press.

- Bogost, I. (2018, marzo 20). Can You Sue a Robocar? The Atlantic. Recuperado de: https://www.theatlantic.com/technology/archive/2018/03/can-you-sue-a-robocar/556007/.

- Bostrom, N. (1998). How long before superintelligence? International Journal of Future Studies, 2.

- Brillouin, L. (1949). Life, Thermodynamics, and Cybernetics. American Scientist, 37(4), 554-568.

- Brockman, J. (Ed.). (2019). Possible Minds: Twenty-Five Ways of Looking at ai. Nueva York: Penguin Press.

- Brooks, R. (2019). The Inhuman Mess Our Machines Have Gotten Us Into. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 54-63). Nueva York: Penguin Press.

- Church, G. M. (2019). The Machine Rights. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 240-253). Nueva York: Penguin Press.

- Dennett, D. C. (2019). What Can We Do? En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 41-53). Nueva York: Penguin Press.

- Deutsch, D. (2019). Beyond Reward and Punishment. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 113-124). Nueva York: Penguin Press.

- Dragan, A. (2019). Putting Humans in the ai Equation. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 134-142). Nueva York: Penguin Press.

- Dyson, G. (2019). The Third Law. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 33-40). Nueva York: Penguin Press.

- Galison, P. (2019). Algorists Dream of Objectivity. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 231-239). Nueva York: Penguin Press.

- Gershenfeld, N. (2019). Scaling. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 160-169). Nueva York: Penguin Press.

- Griffiths, T. (2019). The Artificial Use of Human Beings. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 125-133). Nueva York: Penguin Press.

- Goodfellow, I., Bengio, Y. y Courville, A. (2016). Deep Learning. The mit Press.

- Gopnik, A. (2019). ais versus Four-Year-Olds. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 219-230). Nueva York: Penguin Press.

- Hicks, M. J. y Devaraj, S. (2017). The Myth and the Reality of Manufacturing in America. Recuperado de: https://conexus.cberdata.org/files/MfgReality.pdf.

- Hillis, W. D. (2019). The First Machine Intelligences. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 170-180). Nueva York: Penguin Press.

- Huxley, J. (1942). Evolution: The Modern Synthesis (1a ed.). Londres: George Allen & Unwin.

- Jones, C. A. (2019). The Artistic Use of Cybernetic Beings. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 254-265). Nueva York: Penguin Press.

- Kaiser, D. (2019). “Information” for Wiener, for Shannon, and for Us. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 151-159). Nueva York: Penguin Press.

- Kurzweil, R. (2006). The Singularity Is Near: When Humans Transcend Biology. Nueva York: Penguin Books.

- Lloyd, S. (2019). Wrong, but More Relevant Than Ever. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 1-12). Nueva York: Penguin Press.

- Luhmann, N. (2013). Introduction to Systems Theory. Bodmin, Cornwall: Polity Press.

- Milgram, A. (2013, octubre). Why smart statistics are the key to fighting crime [ted Talk presentada en Long Beach, California].

- Moore, G. E. (1965). Cramming more components onto integrated circuits. Electronics, 38(8), 114-117.

- Obrist, H. U. (2019). Making The Invisible Visible: Art Meets ai. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 206-218). Nueva York: Penguin Press.

- Office for National Statistics. (2019). The probability of automation in England: 2011 and 2017.

- Pearl, J. (2019). The Limitations of Opaque Learning Machines. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 13-19). Nueva York: Penguin Press.

- Pentland, A. (2019). The Human Strategy. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 192-205). Nueva York: Penguin Press.

- Pinker, S. (2019). Tech Prophecy and the Underappreciated Causal Power of Ideas. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 100-112). Nueva York: Penguin Press.

- Ramakrishnan, V. (2019). Will Computers Become Our Overlords? En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 181-191). Nueva York: Penguin Press.

- Russell, S. (2019). The Purpose Put into the Machine. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 20-32). Nueva York: Penguin Press.

- Spencer Brown, G. (1972). Laws of Form. The Julian Press Inc. [publicado originalmente en 1969].

- Tallinn, J. (2019). Dissident Messages. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 88-99). Nueva York: Penguin Press.

- Tegmark, M. (2019). Let’s Aspire to More Than Making Ourselves Obsolete. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 76-87). Nueva York: Penguin Press.

- Von Bertalanffy, L. (1976). General System theory: Foundations, Development, Applications. George Braziller [publicado originalmente en in 1968].

- Wiener, N. (1950). The Human Use of Human Beings. The Riverside Press.

- Wiener, N. (1961). Cybernetics: Or Control and Communication in the Animal and the Machine (2a ed.). The mit Press [publicado originalmente en 1948].

- Wikipedia contributors. (2019). Macy conferences. Recuperado de: https://en.wikipedia.org/w/index.php?title=Macy_conferences&oldid=910537451.

- Wilczek, F. (2019). The Unity of Intelligence. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 64-75). Nueva York: Penguin Press.

- Wolfram, S. (2019). Artificial Intelligence and The Future of Civilization. En Brockman, J. (Ed.), Possible Minds: Twenty-Five Ways of Looking at ai (pp. 266-284). Nueva York: Penguin Press.

Recepción: 03/09/2019. Aprobación: 11/12/2019.